Les plateformes telles que Flightradar24 et ADSB Exchange sont une référence pour suivre les trajets des avions commerciaux et des jets privés. En revanche, peu sont ceux qui savent qu'il est aussi possible de traquer soi-même les avions qui passent à proximité en...

Trucs et Astuces

Retour à l’accueil

Le monde entier est un qactus

Cet article est le fruit d'une enquête au long cours menée depuis juillet 2021 sur un acteur clef de la désinformation français, par OpenFacto et SourcesOuvertes sur Twitter en collaboration avec le site ConspiracyWatch.Il présente toutefois quelques nouveaux éléments...

La gazette syrienne

extrait de la Gazette Syrienne A l'occasion de ses 20 ans le site The Syria Report a lancé deux rubriques gratuitement accessibles: la Gazette Officielle du gouvernement syrien et la rubrique Terrain Logement Propriété. Ce site web connu pour publier des informations...

Y a plein de mails intéressants sur yopmail.com

Introduction http://www.yopmail.com/ est un service de messagerie électronique temporaire, gratuit, et ne nécessitant strictement aucun mot de passe. N'importe qui peut y accéder avec n'importe quel identifiant, lequel peut être soit généré aléatoirement, soit choisit...

#JeSuisProf – OpenFacto met à disposition un petit guide de la vie privée

En réaction aux événements de Conflans Sainte Honorine, OpenFacto met à disposition un petit guide basique sur la vie privée en ligne pour qu'un compte Facebook mal paramétré ou une adresse de domicile publique ne soit pas un frein au travail fantastique et à la...

Reconnaissance faciale et OSINT – Digikam

Inquiétante à plus d'un titre, la reconnaissance faciale peut tout de même s'avérer extrêmement pratique pour l'OSINT. La plus grosse problématique pour son utilisation reste la chaîne d'outils nécessaire : bien souvent des scripts python, des ressources systèmes...

CTF Trace Labs #5 – Recherches de micro-informations, gestion du temps, et Mr Freeze

Quand l'un des membres d'OpenFacto a annoncé sur Slack qu'un nouveau CTF (Capture The Flag) Trace Labs allait avoir lieu le 11 juillet, quelques mains se sont levées pour participer. Quand il a annoncé que cette fois-ci il aurait lieu de 17h à 23h, donc pas de minuit...

Export de Telegram au format csv – introduction à BeautifulSoup

Quand les petites mains ne suffisent plus pour parcourir des quantités monstrueuses de données.Quand les expressions régulières sont hors-jeu face au html.Quand l'agrégation de données dans un beau fichier csv ne semble qu'un rêve lointain.BeautifulSoup (et Python...

Retour sur enquête: monitorer un événement public sur les réseaux sociaux

Dans une enquête pour Bellingcat, Sébastien s’intéressait à la présence d’un militant de l’extrême-droite française au festival néo-nazi “Asgardsrei” qui avait lieu en Ukraine en décembre 2019. A travers cet exemple, il fait ici un rappel des techniques basiques pour...

RADIOAMATEURS : une source méconnue de l’OSINT ?

L'ami Gimli nous proposait un chouette challenge sur Twitter, de la géolocalisation à base de source radio-amateur.L'occasion pour lui d'écrire l'article ci-dessous, mêlant, comme souvent ici, méthodologie et analyse technique! De nombreux articles et méthodologies...

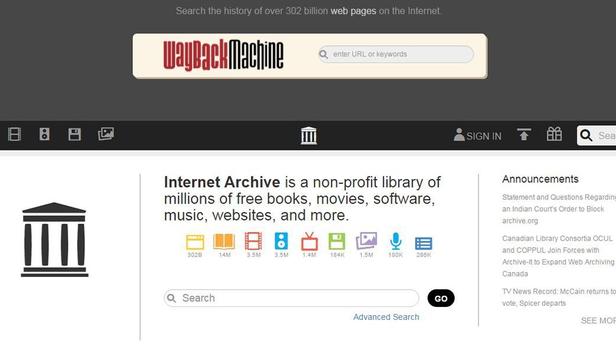

Récupérer des fichiers pdf en masse sur Archive.org

Le site d'archivage du web bien connu Archive.org ne stocke pas seulement les versions des sites internet qu'il scrute. Il collecte et indexe également les fichiers déposés sur ces serveurs, et notamment les fichiers pdf. Dans le cadre d'une recherche OSINT, il peut...

Trace Labs, CTF et tatouages

Samedi 11 avril 2020, 23h59. Plus qu'une minute avant le début des recherches... Si la gamification est un concept qui touche de plus en plus de domaines, c'est peut-être ici une des meilleures applications qui en découle. Dans moins de 60 secondes s'apprêtait à...

Rejoignez-nous.

Adhérez à OpenFacto et améliorez vos techniques de recherche en sources ouvertes.